1. 向量的大小

(a) L1 范数(Taxicab distance / 曼哈顿距离)

只能走水平和垂直路径时的距离:

更一般地(n 维向量 ):

(b) L2 范数(Euclidean distance / 直线距离)

像直升机飞一样走直线:

二维:

n 维:

默认情况下, 表示 L2 范数。

向量组:一组向量的集合的名称

线性相关:其中有向量可以被其他向量线性表示

线性表示:某些向量数乘后的组合

- 如果两个向量组能互相线性表示,则称二者等价

向量空间(张成空间 / span):几个向量的线性表示的组合的活动范围。可以用向量组来表示

- R

- 三维的原点与二维原点维度不同,不能被视为二维,但仍然可以作为向量空间,只不过是三维向量空间

- 子空间

向量的表示方法

-

行向量:

-

列向量:…

-

也可以用 、x 表示向量。

-

括号与方括号只是记号差异,无概念区别。

Linear Transformations

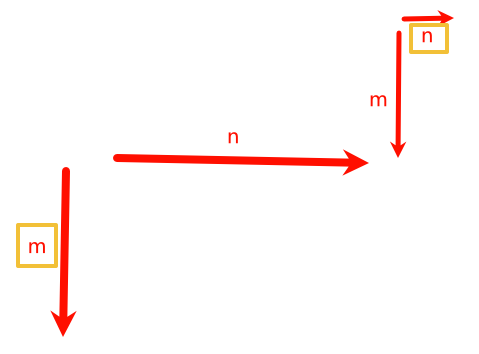

Parallelogram rule:平行四边形的对角线 Difference of vectors:平行四边形的另一条对角线 Scalar multiplication:拉长、缩短、反向

1. 点积(Dot Product)定义

给定两个 维向量

点积定义:

另一种常用记法:

2. 例子:水果价格

- 水果数量向量:

- 单价向量:

总价:

矩阵写法(行向量 × 列向量):

3. 点积与范数(Norm)的关系

L2 范数:

例:

4. 转置(Transpose)

- 列向量 → 行向量:

- 行向量 → 列向量:

- 矩阵转置: 若 是 矩阵, 是 矩阵,行列互换:

5. 关键要点

- 点积本质上是对应元素相乘再相加

- 几何意义(二维/三维):

- 范数是点积的特殊情况(向量和自己点积再开方)

- 转置用于调整向量形状(行 vs 列)以便做矩阵运算

6. 点积与向量夹角关系

6.1 正交(Orthogonal)与点积为 0

- 定义:若 ,则 与 正交(垂直)。

- 例子:

两向量正交。

6.2 点积的几何公式

对于任意 ,有:

其中:

- 是 与 的夹角

- 表示 L2 范数(长度)

6.3 投影解释

- 点积等于一个向量在另一个向量上的投影长度 × 另一个向量的长度

- 无论是 投影到 ,还是 投影到 ,点积结果相同

公式:

6.4 点积符号与方向关系

- :夹角 ,同向成分为正

- :夹角 ,正交

- :夹角 ,反向成分为负

例:

设

6.5 几何区域

- 对于固定向量 :

- 正交区域:所有与 点积为 0 的向量,位于一条垂直于 的直线上

- 正点积区域:位于 正方向的半平面

- 负点积区域:位于 反方向的半平面

7. 矩阵与向量相乘

7.1 点积回顾

- 两个向量的点积(dot product):

- 例:

可写为:

7.2 系统的线性方程组

假设有三个未知数 和三个方程:

每个方程都可表示为 行向量 与 列向量 的点积:

7.3 矩阵-向量乘法

将系数向量 按行堆叠 形成矩阵:

意义:

- 矩阵 × 向量 = 多个点积的堆叠。

- 每一行与列向量的点积得到一个结果,结果按行组成新的列向量。

7.4 维度匹配条件

- 若矩阵是 ,向量必须是 。

- 乘积结果是 向量。

- 列数 = 向量长度,否则点积无法定义。

7.5 矩形矩阵情况

- 矩阵不一定是方阵。

- 例: 矩阵 × 长度为 3 的列向量 → 结果是长度为 4 的列向量。

7.6 总结

- 矩阵 × 向量本质是批量点积。

- 这是表达和求解线性方程组的标准方式:

其中:

- 是系数矩阵

- 是未知变量列向量

- 是常数列向量

Matrices as linear transformations:把平面(或更高维空间)上的每个点,按照某种结构化规则映射到另一个点。

性质:线性变换——原点不变的基变换导致向量变换

Linear transformations as matrices

矩阵乘法在神经网络中的应用:线性分类器与感知机

1. 问题背景:垃圾邮件分类

- 数据集中有两个高相关词:lottery 和 win

- 目标:建立一个分类器(classifier)来判断邮件是否为垃圾邮件(spam)

2. 分类器机制

- 为每个词赋一个权重(score/weight)

- 例:

lottery = 3,win = 2

- 例:

- 邮件得分 = 每个词出现次数 × 对应权重,再求和(点积 dot product)

- 阈值判断(threshold):

- 分数 ≥ 阈值 → 分类为垃圾邮件

- 分数 < 阈值 → 分类为非垃圾邮件

例:

lottery=1,win=1,阈值=1.5- “win win lottery” → → spam

3. 线性分类器的几何解释

- 横轴:lottery 出现次数

- 纵轴:win 出现次数

- 分类边界:

- 直线将平面分为正类区域(spam)和负类区域(not spam)

4. 矩阵形式

设:

- 数据矩阵 (行=邮件,列=特征,即词的出现次数)

- 权重向量

- 阈值

预测:

5. 阈值与偏置(Bias)

- 阈值判断 等价于

- 将 作为 bias,可写成:

- 检查 → spam

矩阵实现:

- 在数据矩阵 增加一列常数

- 在权重向量 增加一个分量

6. AND 运算的感知机实现

- 数据: → 1(是)当且仅当 且

- 模型:

- 分类边界:

- 对应单层感知机(Perceptron):

- 输入

- 计算

- 激活函数(step function):,否则

7. 感知机公式

- 权重 :特征重要性

- 偏置 :调整决策边界位置

- 激活函数:将线性结果转为类别(0/1)